「マルチモーダルAI」という言葉を最近よく耳にするようになったけれど、「一体どういう意味?」「今までのAIと何が違うの?」と疑問に思っていませんか? ChatGPTの進化版であるGPT-4oやGoogleのGeminiなど、話題のAIサービスの多くがこのマルチモーダルAIの能力を備えています。これは、AIがテキスト(文字)だけでなく、画像や音声など、複数の種類の情報を同時に理解し、扱えるようになった、AIの大きな進化を示す言葉なのです。

この記事では、マルチモーダルAIの基本的な意味から、その「すごさ」、具体的な活用例、そして未来の可能性まで、専門知識がない方でもイメージが掴めるように、わかりやすく解説していきます。

Contents

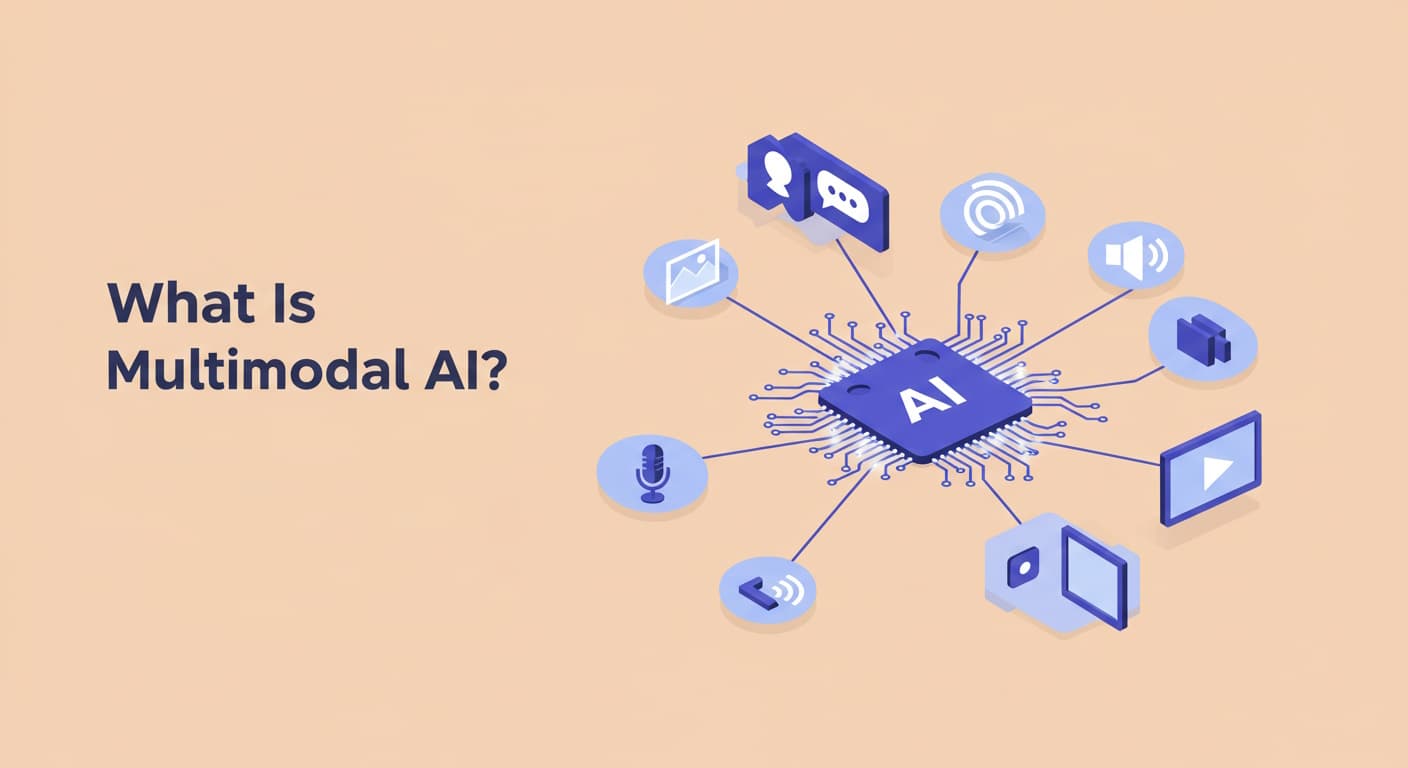

マルチモーダルAIとは?一言でいうと「複数の情報を扱えるAI」

マルチモーダルAIの「マルチモーダル」とは、「複数の種類(モード)の情報」という意味です。つまり、マルチモーダルAIとは、テキスト(文字)、画像(写真やイラスト)、音声(話し声や音楽)、動画といった、異なる種類の情報を複数組み合わせて理解したり、処理したり、生成したりできるAIのことを指します。

まず、「モーダル(Modality)」という言葉ですが、これは単に「情報の種類や形式」と考えてください。主なモーダルには以下のようなものがあります。

- テキスト(文字情報): 文章、単語、コードなど

- 画像(視覚情報): 写真、イラスト、図形など

- 音声(聴覚情報): 人の声、音楽、物音など

- 動画(視覚+聴覚+時間情報): 映像と音声を組み合わせたもの

- その他:センサーデータ、表データなど

これまでのAIは、特定の単一のモーダルだけを扱うのが得意でした。例えば、「文章を翻訳するAI(テキスト専門)」、「画像に写っているものを認識するAI(画像専門)」、「音声を聞き取って文字にするAI(音声専門)」といった具合です。これをシングルモーダルAIと呼びます。

それに対して、マルチモーダルAIは、これらの複数の情報を統合して扱える点が画期的なのです。まるで、私たち人間が「目(視覚)」と「耳(聴覚)」を使って物事を同時に理解するように、マルチモーダルAIも複数の「感覚」を通して情報を処理し、より深く、より柔軟に世界を理解しようとしている、とイメージすると分かりやすいかもしれません。映画を見るとき、映像(画像)とセリフや音楽(音声)を同時に理解していますよね。マルチモーダルAIは、それに近いことをコンピューター上で実現しようとしているのです。

マルチモーダルAIのここがスゴイ!情報を組み合わせる能力

マルチモーダルAIの真の「すごさ」は、単に複数の種類のデータを扱えるだけでなく、それらの異なる情報(モーダル)を相互に関連付け、組み合わせて理解したり、一方から他方を生成したりする能力にあります。まさに、複数の情報を統合して「意味」を読み取る力です。

具体的にどんなことができるのでしょうか?

- 画像とテキストの連携

- AIに画像を見せると、その画像の内容を説明する文章(キャプション)を自動で生成してくれます。AIが画像(視覚情報)を理解し、それをテキスト(言語情報)に変換しているのです。

- 逆に、「夕焼けの海辺を歩く犬」のような文章(テキスト)をAIに与えると、その説明に合った画像を生成してくれます(Text-to-Image)。言葉の概念を視覚的なイメージに変換しています。

- 音声とテキスト(+α)の連携

- 人が話した音声(聴覚情報)を認識してテキスト(文字情報)に変換したり(音声認識)、その逆(テキスト読み上げ)はもちろんのこと、さらに高度なことができます。

- 例えば、2024年に登場したGPT-4oのように、ユーザーが話しかけながらスマホのカメラで何かを映すと、AIが音声と画像の両方をリアルタイムで理解し、「その赤いリンゴについてもっと教えて」といった指示に応えることが可能になってきています。

- 動画(画像+音声+時間)の統合理解

動画は、連続する画像、音声、そして時間の流れという複数の情報が組み合わさっています。マルチモーダルAIは、動画全体の内容を理解し、「この動画で何が起きましたか?」という質問に答えたり、重要なシーンを要約したりすることができます。

このように、異なる種類の情報をバラバラに処理するのではなく、それらを結びつけて、より豊かな文脈(コンテクスト)の中で物事を捉えることができるのが、マルチモーダルAIの最大の強みです。これにより、従来のシングルモーダルAIでは難しかった、より人間に近い、柔軟で高度なタスクが可能になりつつあります。研究によれば、複数の情報を組み合わせることで、単一の情報だけを使うよりもタスクの精度が向上するケースが多く報告されています。

マルチモーダルAIには何ができる?主な機能と例

マルチモーダルAIが持つ「情報を組み合わせる能力」によって、具体的にどのような機能が実現されているのでしょうか。主な機能と簡単な例を見ていきましょう。

- 機能1:画像・動画の説明文生成(キャプション生成)

画像や動画の内容をAIが理解し、それを自然な文章で説明します。- 例:ウェブサイトの画像に自動で代替テキスト(alt属性)を付与し、アクセシビリティを向上させる。防犯カメラの映像から、何が起きたかを要約して報告する。

- 機能2:テキストからのメディア生成(Text-to-Media Generation)

入力されたテキスト(プロンプト)に基づいて、画像、イラスト、動画、音楽などをAIが生成します。- 例:ブログ記事の内容に合った挿絵をAIに作成してもらう。短い説明文からプレゼンテーション用の動画クリップを生成する。(動画や音楽生成は現在も急速に進化中です)

- 機能3:視覚的な質問応答(Visual Question Answering – VQA)

画像や動画を見ながら、それに関する質問をテキストや音声で行うと、AIが内容を理解して回答します。- 例:旅行先の写真を見せて「この建物の名前は何ですか?」と質問する。料理動画を見ながら「次に加える調味料は何ですか?」と尋ねる。

- 機能4:高度な音声対話・インターフェース

音声での指示と、画面上の情報やカメラ映像などを組み合わせてAIが理解し、応答や操作を行います。- 例:「この中で一番安い商品をカートに入れて」と音声で指示しながら、スマートフォンの画面に表示された商品リストをAIが認識する。

- 機能5:マルチモーダルデータの統合分析

複数の異なる形式のデータ(例:顧客のレビュー文章、購入履歴の表データ、問い合わせ時の音声記録など)を組み合わせて分析し、より深い洞察を得ます。- 例:医療分野で、レントゲン画像(画像データ)と医師の診断記録(テキストデータ)をAIが統合的に分析し、診断精度を高める支援を行う。

これらの機能は、それぞれ独立しているだけでなく、組み合わさることでさらに高度な応用が可能になります。

マルチモーダルAIはどこで使われている?身近な活用事例

マルチモーダルAIは、もはや研究室の中だけの技術ではありません。現在、すでに私たちの身近なところで活用され始めています。ここでは、代表的な5つの活用事例をご紹介します。

- 次世代AIアシスタント(対話型AIの進化)

- 代表例: GPT-4o(OpenAI)、Gemini(Google)など(2023年後半〜2025年にかけて登場・進化したモデル)

- 活用: これらの最新AIモデルは、テキストだけでなく、ユーザーがアップロードした画像やスクリーンショットの内容について質問したり、音声で自然に会話したりする能力を備えています。まさにマルチモーダルAIの代表格であり、情報収集やアイデア出し、学習支援などの方法を大きく変えつつあります。

- クリエイティブ支援ツール(画像・動画生成など)

- 代表例: Midjourney, Stable Diffusion, DALL-E 3(画像生成)、Sora(OpenAI、動画生成 – 2025年現在も限定公開・開発中)など

- 活用: テキストで指示するだけで、プロ並みのイラストや画像を生成したり、短い動画を作成したりできます。デザイナー、マーケター、コンテンツクリエイターなどの創造性を支援し、制作プロセスを効率化しています。

- スマートフォンやPCの新機能

- 代表例: Googleレンズのような画像検索機能、OSレベルでのAI機能統合(例: Windows Copilot, macOSの将来機能)

- 活用: スマートフォンのカメラをかざして目の前にあるものを検索したり(画像+テキスト)、スクリーンショットの内容についてAIに質問したり、音声操作と画面表示を連携させたりといった機能に、マルチモーダルAI技術が活用されています。視覚障碍者向けに画像の内容を音声で説明するアクセシビリティ機能も向上しています。

- Eコマース(ネット通販)とマーケティング

- 活用: 顧客が「いいね!」した画像(視覚情報)と購入履歴(テキスト・表データ)を組み合わせて、よりパーソナルな商品推薦を行う。AR(拡張現実)を使ったバーチャル試着(カメラ映像+商品データ)。広告用のキャッチコピー(テキスト)とそれに合う画像(イメージ)をセットで生成するなど。

- 教育・学習支援プラットフォーム

- 活用: テキスト教材に連動する図や動画を提示したり、生徒が描いた図について質問に答えたりするインタラクティブな学習環境。語学学習アプリで、発音(音声)と口の動き(動画)、意味(テキスト)を統合的にフィードバックするなど。

これらの事例はほんの一部であり、今後さらに多くの分野でマルチモーダルAIの活用が広がっていくと考えられます。

マルチモーダルAIの今後の可能性と課題

複数の情報を統合的に扱えるマルチモーダルAIは、AI技術の未来に大きな可能性をもたらしますが、同時に解決すべき課題も存在します。

今後の可能性

- より人間らしいAIとの対話: 視覚や聴覚など複数の情報から文脈を深く理解することで、人間同士のコミュニケーションに近い、自然でスムーズな対話が実現する可能性があります。

- 創造性のさらなる拡張: テキスト、画像、音楽などを組み合わせた、今までにない新しい形のコンテンツ生成や芸術表現が生まれるかもしれません。

- 科学技術の加速: 医療、材料科学、気象予測など、様々な種類の複雑なデータを統合的に分析することで、新たな発見や技術革新が加速する可能性があります。(例:ゲノム情報+タンパク質構造+論文テキストの統合解析)

- 高度なロボット制御: ロボットがカメラ(視覚)、マイク(聴覚)、センサー(触覚など)からの情報を統合して周囲の状況をより正確に把握し、複雑な作業を行えるようになる可能性があります。

主な課題

- モデルの複雑性と開発・運用コスト: マルチモーダルAIは、扱う情報の種類が増えるほどモデル構造が複雑になり、学習に必要なデータ量や計算能力(高性能なGPUなど)、開発コストが増大する傾向があります。

- 異種データの統合・融合の難しさ: テキスト、画像、音声など、性質の全く異なるデータをどのように効果的に組み合わせ、相互の関係性を学習させるかは、技術的に依然として難しい課題です。

- 評価の難しさ: 生成されたコンテンツ(特に画像や動画)の品質や、複数の情報に基づいたAIの判断の妥当性を客観的に評価するための確立された指標がまだ少ないです。

- バイアス(偏見)の増幅リスク: ある情報(例:画像)に含まれるバイアスが、別の情報(例:生成されるテキスト)に影響を与えたり、複数のバイアスが複合的に増幅されたりする可能性があります。

- 倫理的な懸念: 高度なディープフェイク(動画+音声)の生成・悪用、複数ソースからの個人情報収集・統合によるプライバシー侵害のリスクなど、倫理的な課題への対応も急務です。

これらの課題を克服していくことで、マルチモーダルAIはさらに社会に貢献する技術へと発展していくでしょう。

まとめ:マルチモーダルAIとは、AIの理解力と表現力を飛躍させる次世代技術

今回は、急速に注目度が高まっている「マルチモーダルAI」について、その基本的な意味から、情報を組み合わせる能力、具体的な機能や活用事例、そして未来の可能性と課題までを、できるだけ分かりやすく解説しました。

マルチモーダルAIは、AIが世界をどのように「見て」「聞いて」「理解」し、そして「表現」するかの能力を飛躍的に向上させる、まさに次世代のAI技術と言えるでしょう。この技術の動向を理解することは、今後の社会やビジネスの変化を読み解く上で、ますます重要になっていきます。